统计推断

Likelihood

似然函数:表示统计模型参数中似然性的(参数的)函数

- $Y$:观测所得结果,事件 $Y$

- $W$:模型参数

- $\alpha$:正常量

似然函数可以理解为 条件概率的逆反

- 似然:在已知某些观测所得结果上,对有关事物性质的参数进行估计

- 似然性:某个参数为特定值的可能性

- 单独查看某个似然值无价值,要将各种似然值一起比较

- 概率:在已知某些参数上,预测之后观测所得到结果

- 似然:在已知某些观测所得结果上,对有关事物性质的参数进行估计

形式上,似然函数也是条件概率函数,但关注统计模型中参数

- 似然函数不满足归一性,乘正常数仍然是似然函数

- 同一似然函数代表的模型中,某个参数具有多种可能,如果存在参数使得似然函数值最大,则该值为最合理的参数值

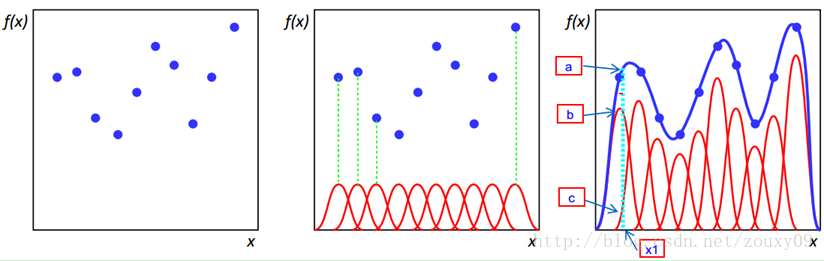

- 假设不同模型(经验得到),选择不同的统计模型

- 则有不同的概率密度(分布)函数,得到不同的似然函数

应用

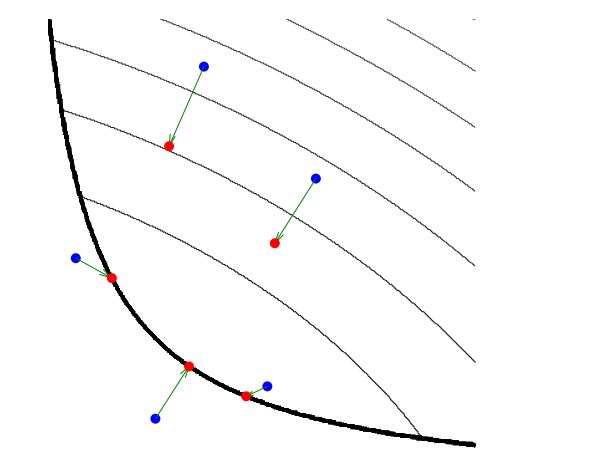

最大似然估计:选取似然函数,整理之后求最大值点

- 实际中一般选取似然函数对数作为求解对象,结果同直接求似然函数最大值点

- 似然函数最大值点不一定唯一,也不一定存在

- 相较于矩估计

- 精度较高,信息损失少

- 计算量大

似然比检验:利用似然函数检测假设、限制是否有效

- 将加入某个限制的复杂某些的似然函数最大值和简单模型的似然函数最大值比较,检测某个参数限制是否正确

- 若参数限制正确,则不应造成似然函数最大值的大幅变动

- 尼曼-尼尔森引理 说明:似然比检验是所有具有同等显著性差异的检验中,最有统计效力的检验

- 将加入某个限制的复杂某些的似然函数最大值和简单模型的似然函数最大值比较,检测某个参数限制是否正确

条件概率分布似然函数

- $P$:(所选择)统计模型的概率分布函数

- $\tilde P$:$X,Y$ 的实际分布

- $X,Y$:离散随机变量,$X$ 自变量观察值、$Y$ 因变量观察值

- $W$:条件概率分布 $P$ 的参数

- $N$,$N_{x,y}$:样本数量,取值为 $x,y$ 的样本数量

这里是条件概率分布的似然函数,用 $(X,Y)$ 联合分布同样

- 考虑 $W$ 是条件分布参数,与 $X$ 分布无关,有 $P(X|W) = P(X)$

- 再考虑似然函数乘正常数不改变性质,则结果同上

对数似然函数中,样本量 $N$ 可省略